Downloading og republishing {{forumTopicSubject}}

Hej. Jeg er i gang med et project, (det skal siges at det ikke er ulovligt eller kraenkende paa nogen maade), som jeg har brug for noget hjaelp til.

Jeg vil downloade mange filer fra en side, og saa lave min egen database af de filer. Filerne kan kun downloades ud fra direkte links.

Derefter skal de organiseres, saa man kan overskue og soege efter dem i en database.

Problem #1 er at det er meget svaet at finde et program, der kan downloade saa mange filer, blot ud fra links.

Problem #2 jeg mangler ideer/inspiration/programmer til hvordan man analyserer og organiserer html-filer.

Ideer, tips og rettelser modtages med kyshaand ![]()

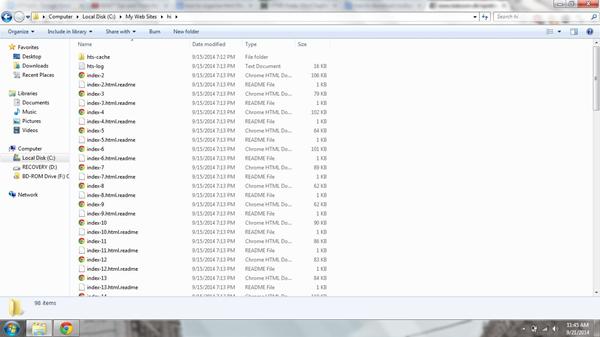

PS, lige nu bruger jeg HTTrack til at downloade filerne. Paa billedet ses HTML-filerne som skal bruges til batabasen (der vil i alt vaere over 3.000.000 filer... Hvis det ikke er muligt vil der vaere 100.000 filer.

sep 2008

Følger: 11 Følgere: 12 Emner: 95 Svar: 4.911

sep 2008

Følger: 11 Følgere: 12 Emner: 95 Svar: 4.911

maj 2012

Følger: 1 Følgere: 1 Emner: 2 Svar: 41

Hvis du er til linux kan du kigge på wget.

Downloading og republishing